Neuronale Netzwerke, besonders grosse Sprachmodelle, sind aus Parametern aufgebaut und «nähren» sich von Tokens. Die Menge dieser Tokens zeigt, wie viele Informationen – vergleichbar mit Büchern – die AI «gelesen» hat. Doch die Tokens finden nicht nur hier Verwendung; sie spielen auch in anderen Bereichen eine wichtige Rolle als Masseinheit.

Let's dive in...

In unserem letzten Blogbeitrag hast du einen ersten Einblick in die Welt der

Parameter bei AI-Modellen bekommen. Jeder dieser Parameter ist ein Schlüsselelement, das während des Trainingsprozesses feinjustiert wird, um die Leistungsfähigkeit und Genauigkeit des Modells zu optimieren. Die Anzahl dieser

Parameter spielt eine entscheidende Rolle für die Komplexität und Fähigkeit des

Modells.

Ein weiteres wichtiges Element sind die Tokens. Stell dir einen Token als einen digitalen Baustein vor – die kleinste Einheit von Daten, die ein Modell verarbeiten

kann. Bei Sprachmodellen wie GPT-3 und GPT-4 kann ein Token ein Wort oder ein

Teil eines Wortes sein. Diese Zerlegung des Textes in Tokens ermöglicht es dem Modell, Sprache effektiv zu «verstehen» und zu verarbeiten.

Nicht zu vergessen ist das Lernmaterial des Modells, welches ebenfalls in Tokens ausgedrückt wird. Die Menge des Lernmaterials, die ein AI-Modell während seines

Trainings verarbeitet, ist ausschlaggebend für seine Entwicklung und Leistung. Diese Grösse, ausgedrückt in der Anzahl von Tokens, ist ein spezifisches Attribut jedes Modells und verrät dir viel über die Vielfalt der Informationen, die es während des Trainings aufnimmt.

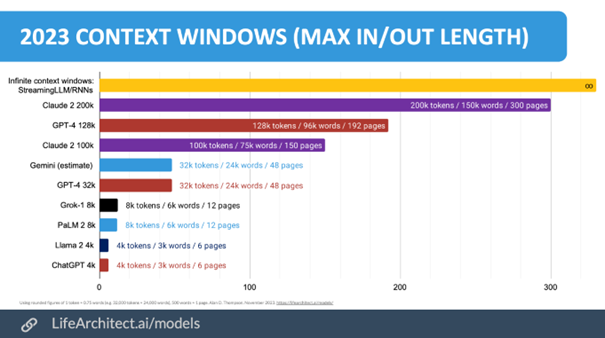

Ein weiterer wichtiger Aspekt ist das «Context Window». Es bezeichnet die Anzahl von Tokens, die ein Modell gleichzeitig im Gedächtnis behalten kann, beziehungsweise als Prompt eingegeben werden können. Zugleich ist es auch die maximale Grösse der Antwort, welche ein Model erstellen kann. GPT-3.5 kann sich beispielsweise an bis zu 4096 Tokens erinnern, was etwa 3000 Wörtern entspricht. GPT-4 für Consumer geht hier noch weiter und erweitert dieses Fenster auf bis zu 32.000 Tokens – genug, um umfangreichere Texte wie ein ganzes Filmskript zu verarbeiten.

Diese drei Aspekte – die Anzahl der Parameter, die Grösse des Lernmaterials und des Context Windows – variieren stark zwischen verschiedenen AI-Modellen. Mit diesem Wissen kannst du die Leistungsfähigkeit und Unterschiede zwischen den AI-Modellen besser verstehen und bewerten. Diese drei Merkmale beeinflussen auch, wie viel Energie diese Modelle zum Lernen und Betreiben verbrauchen, was für die Hersteller kommerzielle Überlegungen mit sich bringt.

Für eine aktuelle Liste und weitere Details zu den neuesten AI-Modellen findest du

hier eine sehr gute Übersicht.

https://docs.google.com/spreadsheets

Key Takeaways

- Ein Token ist die kleinste Einheit, die ein Large Language Model (LLM) verarbeiten kann.

- Die Menge des Trainingsmaterials wird in Anzahl der Tokens angegeben.

- Das Context Window definiert die maximale Anzahl an Tokens, die ein LLM verarbeiten kann, und bestimmt gleichzeitig den maximalen Input und Output des Modells.

👉 Demnächst auf unserem Blog:

Im fünften Blogbeitrag «Mit Wörtern rechnen: AI & LLMs für Entscheidungsträger» betrachten wir, wie Grosse Sprachmodelle aus «Büchern» lernen, indem sie Texte in kleine Einheiten, sogenannte Tokens, zerlegen und das Zusammenspiel der

Wörter «verstehen».

Stelle sicher, dass du keinen Beitrag zum AI verpasst und in Zukunft direkt über Neuigkeiten im Bereich Artificial Intelligence informiert bleibst. Registriere dich jetzt für das kostenlose Blog-Abo.

✍️✍️✍️

Hast du weitere Fragen? Dann zögere nicht und kontaktiere uns. Wir helfen dir gerne unter marketing@bithawk.ch weiter.