Grosse Sprachmodelle lernen aus «Büchern», indem sie Texte in kleine Einheiten,

sogenannte Tokens, zerlegen. Diese Modelle achten genau darauf, was links und

rechts von jedem Wort steht und erstellen für jedes Wort riesige Vektoren. Diese

Vektoren enthalten alle möglichen Wahrscheinlichkeiten der Wörter, die in der

Nachbarschaft auftauchen können, wodurch die Modelle das Zusammenspiel der

Wörter «verstehen».

Let's dive in...

Ohne zu sehr ins Detail zu gehen, möchte ich doch einiges dazu erklären, wie man mit Wörtern Berechnungen anstellt und Vorhersagen treffen kann.

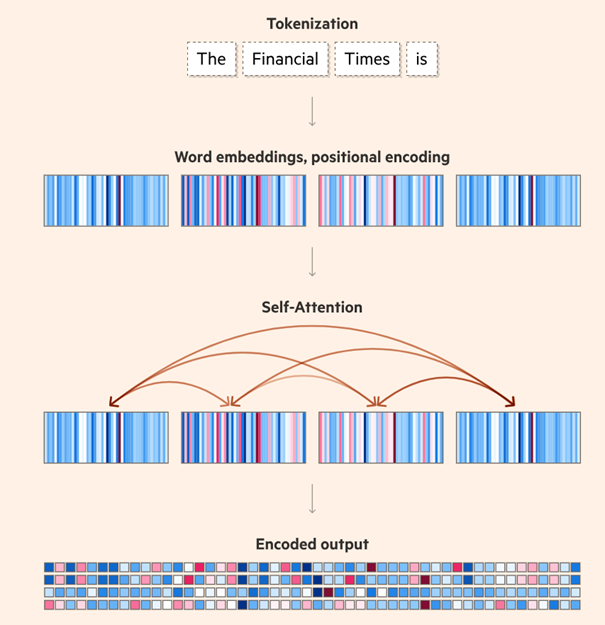

Zunächst wird ein Textblock aus dem Lernmaterial in Tokens zerlegt. Um die Bedeutung eines Wortes zu erfassen, beobachten LLMs diese Trainingsdaten und beachten die umliegenden Wörter. Das Modell verarbeitet diese Wörter und erstellt einen Vektor, bekannt als «Word Embedding», der auf der Nähe der Wörter in den Trainingsdaten basiert. Ein Word Embedding kann Hunderte Werte haben, wobei jeder Wert einen anderen Aspekt der Bedeutung eines Wortes repräsentiert. Genauso wie du ein Haus anhand seiner Merkmale beschreibst – Typ, Standort, Schlafzimmer, Badezimmer, Stockwerke –, quantifizieren die Werte in einem Embedding die sprachlichen Eigenschaften eines Wortes.

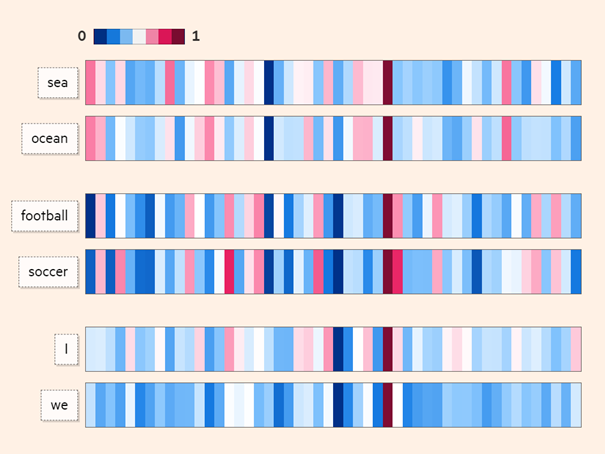

Die Art und Weise, wie diese Charakteristika abgeleitet werden, bedeutet, dass wir nicht genau wissen, was jeder Wert darstellt. Aber Wörter, von denen wir erwarten, dass sie auf vergleichbare Weise verwendet werden, haben oft ähnlich aussehende Embeddings. Im nachfolgenden Beispiel sieht man, dass die Wörter «Sea» und «Ocean» sowie «football» und «soccer» oder «I» und «we» sehr ähnliche «Word Embeddings» haben.

Ein Wortpaar wie «sea» und «ocean» wird vielleicht nicht in identischen Kontexten verwendet («all at ocean» ist kein direkter Ersatz für «all at sea»), aber ihre Bedeutungen liegen nahe beieinander. Embeddings ermöglichen es uns, diese Nähe zu quantifizieren.

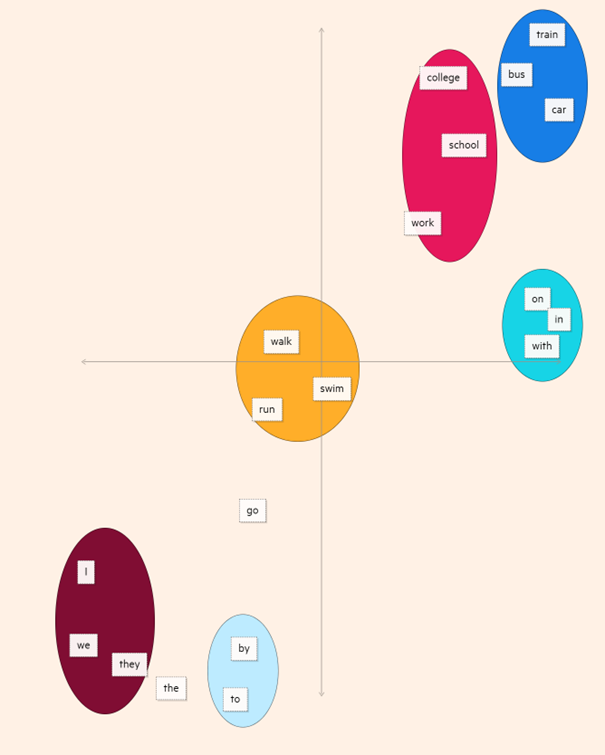

Indem die Hunderte Werte, die jedes Embedding repräsentiert, auf nur zwei Dimensionen reduziert werden, können wir die Abstände zwischen diesen Wörtern deutlicher erkennen. Wir könnten Gruppen von Pronomen oder Transportarten erkennen, und die Fähigkeit, Wörter auf diese Weise zu quantifizieren, ist der erste Schritt bei der Textgenerierung durch ein Modell.

Im Transformer-Modell gibt es zusätzliche Methoden wie «Self-Attention», um die Beziehungen zwischen Wörtern zu berechnen. Im Unterschied zum älteren CNN-Modell erfolgt dies im Transformer-Modell parallel statt seriell. Eine weitere Technik ist die «Beam Search», bei der eine ganze Gruppe von Tokens mit bestimmten Wahrscheinlichkeiten versehen wird.

Für eine umfassendere und detaillierte Erklärung, wie dies genau funktioniert, empfehle ich dir, folgende Originalquelle zu besuchen: ig.ft.com/generative-ai

Dort findest du vertiefende Informationen auf unterhaltsame Art und Weise dargestellt.

Für diejenigen, die sich intensiv mit dem Thema auseinandersetzen möchten, empfehle ich die Website kaggle.com als eine ausgezeichnete Lern-Ressource.

Key Takeaways

- LLMs sind in der Lage, mit Wörtern zu «rechnen» oder sie mathematisch zu verarbeiten.

- Word Embedding: Dies ist ein Vektor, der die Beziehungen eines spezifischen Tokens zu den umliegenden Tokens abbildet.

- Self-Attention: Ein Prozess, der die Beziehungen zwischen allen Tokens in einem Text erfasst und versteht.

👉 Demnächst auf unserem Blog:

Im sechsten Blogbeitrag «RAG Modelle: AI & LLMs für Entscheidungsträger» steht das RAG-Modell im Fokus. Ein Modell, das keine eigenständige KI-Modelltechnologie, sondern eine Methode zur geschickten Integration grosser Sprachmodelle ist. Sei gespannt, wir freuen uns, wenn du dran bleibst.

Stelle sicher, dass du keinen Beitrag zum AI verpasst und in Zukunft direkt über Neuigkeiten im Bereich Künstliche Intelligenz informiert bleibst. Registriere dich jetzt für das kostenlose Blog-Abo.

✍️✍️✍️

Hast du weitere Fragen? Dann zögere nicht und kontaktiere uns. Wir helfen dir gerne unter marketing@bithawk.ch weiter.